In den Mathematikvorlesungen der Fakultät Mobilität und Technik haben Gunther Schaaf und ich während der Pandemie Online-Mathematiktests mit automatisierter Bewertung eingeführt, die die bis dahin etablierte einstündige Midterm-Klausur in der Semestermitte ersetzen. Nach diesem Vorbild erprobe ich in diesem Wintersemester 2023/24 Kurztests in Mathematik 1 in den Studiengängen Mechatronik und Digital Engineering in der Fakultät Wirtschaft und Technik. Dabei haben wir seit der Konfiguration der ersten Tests 2019 [1] sehr viele Testeinstellungen in Moodle durchprobiert, die natürlich jedes Mal mit bestimmten Vorstellungen von Bewertungen und der Rolle der Tests einhergehen. Auch wir Beteiligten sind mittlerweile nicht immer ganz sicher, welche Einstellungen sich bewährt haben, deshalb dient dieser Blogpost nicht zuletzt der Dokumentation unserer Konfigurationen.

Für die Version mit weniger Text und mehr Visualisierung finden sich hier der Screencast zur Einstellung der Spielwiese und hier ein weiterer zur Konfiguration der Tests.

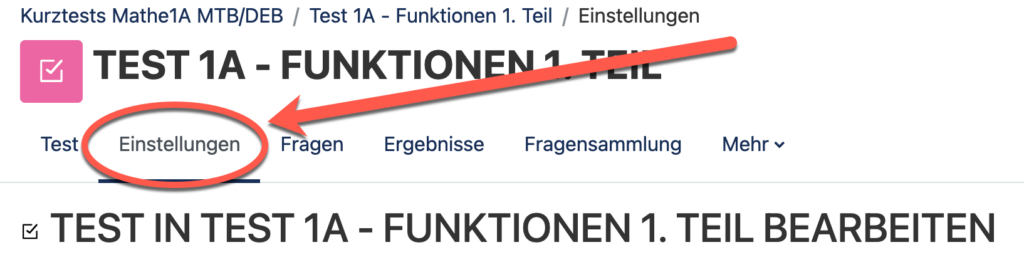

In diesem Post wird vorausgesetzt, dass die Aufgaben („Fragen“) in Moodle bereits angelegt sind und die maximale Punktzahl bzw. die Verteilung die Aufgaben unter dem Reiter Fragen bereits erfolgt ist. Hier geht ausschließlich um den Reiter „Einstellungen“ wie rechts gezeigt.

Kurzbeschreibung der Tests

Die Tests zeichnen sich dadurch aus, dass sie sowohl summative wie auch formative Bewertungselemente enthalten [2]: von 5 Tests müssen 4 mit einer Mindestpunktzahl von 75% bestanden sein, um einen Klausurbonus zu erhalten. Damit sind sie als Teil der Prüfungsleistung und am Abschluss von Einheiten eher summativ. Gleichzeitig darf jeder Test im Vorfeld beliebig oft geübt werden auf einer „Spielwiese“, für die es auch jedes Mal Feedback gibt, zumindest in der Form der Angabe von Punktzahl und der korrekten Lösung. Dieses Element ist also eher formativ. Da die Aufgaben randomisiert sind (also sehr viele unterschiedliche Varianten jeder Aufgabe existieren, die sich durch beispielsweise Zahlenwerte unterscheiden), ist die Wahrscheinlichkeit, exakt dieselbe Aufgabe wie im Test zu erhalten, auch bei vielen Übeversuchen eher klein (und diese kleine Wahrscheinlichkeit ist vermutlich eher ein Ansporn). Details zu den Tests finden sich auch in [3, 4].

An dieser Stelle vielleicht noch ein Hinweis: Bei diese Aufgaben handelt es sich in weiten Teilen im einfache Basisaufgaben (niedrige Stufen in der Bloomschen Taxonomie [5]), d.h. das Ziel ist das Einüben von Routinen wie mit dem klassischen „Päckchenrechnen“ im Mathematikunterricht. Für das Ausbilden komplexer Problemlese- oder Modellierungskompetenz ist dieses Vorgehen natürlich nicht geeignet – die Aufgaben sind also nicht Klausurniveau.

Einstellungen: Spielwiese/formative Übetests

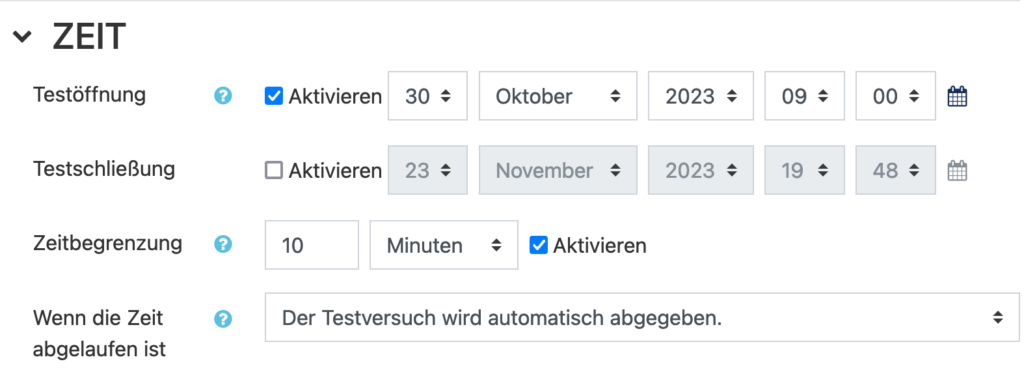

Zeit:

- Es ist für die Übetests kein Schließungszeit angegeben, aber ein Zeitlimit pro Durchführung.

- Die Tests dürfen gerne auch bis zur Klausurenphase genutzt werden. Implikation: Der Test ist nie „geschlossen“, was bei der Einstellung der Bewertungen berücksichtigt werden muss.

- Die Option „Der Testversuch wird automatisch abgegeben“ hat sich bewährt – das vermeidet den Fall, dass Studierende den finalen Klick zur Abgabe trotz bearbeiteter Aufgaben vergessen. Außerdem lassen sich damit im Nachgang alle Ergebnisse als abgeschlossen anzeigen.

Bewertung

- Jeder Test ist auf eine Maximalpunktzahl von 20 Punkten skaliert, die Bestehensgrenze liegt bei 75%, also 15 Punkten.

- Für den formativen Test gibt es eine unbegrenzte Anzahl an Versuchen, von denen jeweils der beste bewertet wird.

Fragenanordnung (Testnavigation)

- Jede Frage wird auf einer neuen Seite angezeigt. Falls mehrere Fragen auf einer Seite erscheinen sollen (oder ein Infotext und eine Frage), lassen sich die Umbrüche auch bei den Fragen direkt einstellen.

- Für den formativen Test gibt es eine unbegrenzte Anzahl an Versuchen, von denen jeweils der beste bewertet wird.

Frageverhalten

- Antworten innerhalb der Fragen mischen: Lassen wir zu – allerdings betrifft das nur manche Fragetypen wie beispielsweise Multiple-Choice-Tests oder Zuordnungsfragen.

- Frageverhalten: Spätere Auswertung. Die direkte Auswertung bietet sich beispielsweise bei Selbstlernkursen an. Dann kann direkt nach jeder Frage entschieden werden, ob die Antwort korrekt war und u.U. mit Abzügen direkt eine Korrektur vorgenommen werden. Die Option einer Selbsteinschätzung habe ich noch nicht ausprobiert.

- Jeder Versuch basiert auf dem vorigen: Das möchten wir hier nicht, bietet aber die Möglichkeit, dass bei einem nächsten Versuch mit den Ergebnissen des alten gestartet wird. Das ist auch mit der Randomisierung der Aufgaben in unserer Anwendung nicht sinnvoll.

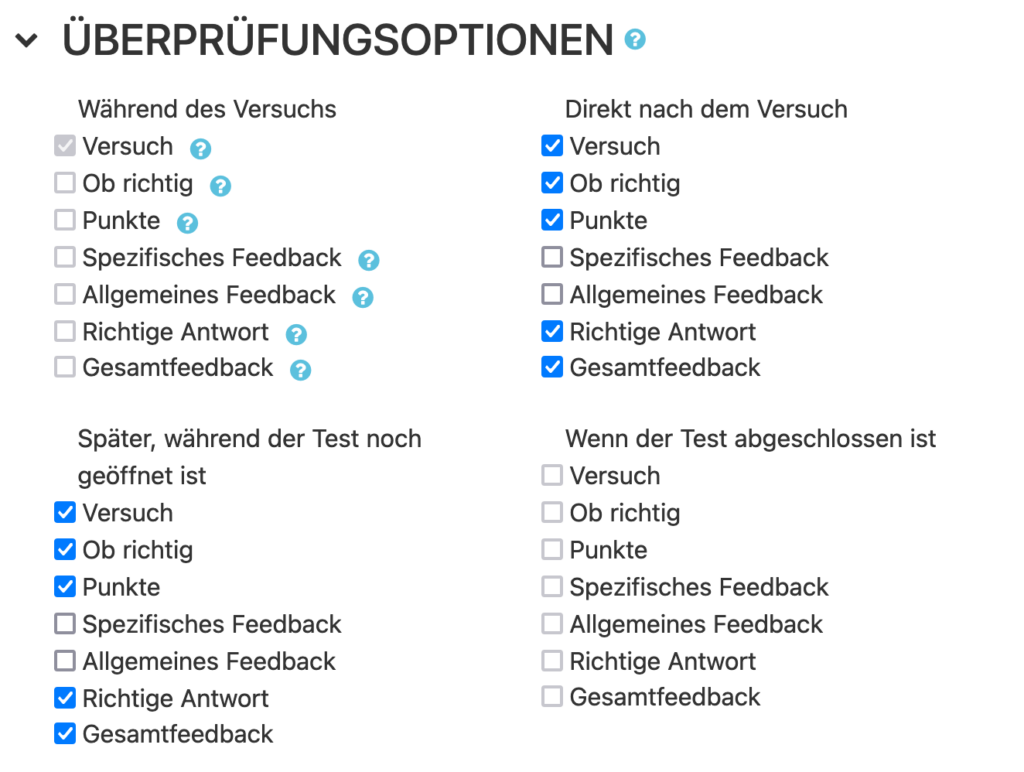

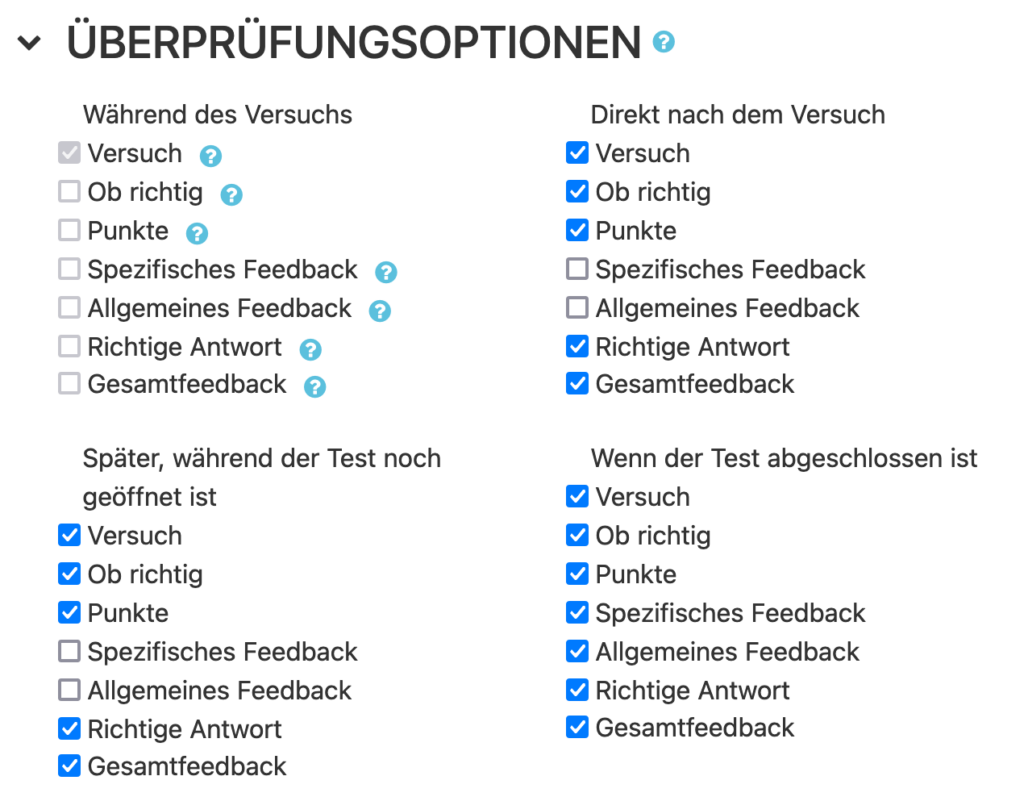

Überprüfungsoptionen:

- Während des Versuchs: sollen die Ergebnisse nicht angezeigt werden..

Direkt nach dem Versuch (also unmittelbar nach Abschluss) sowie

Später, wenn der Test noch geöffnet ist

soll für unsere Anwendung nur angezeigt werden, welche Aufgaben richtig waren, welche Punktzahlen erreicht wurden und wie die richtigen Antworten lauteten. - Bei der Erstellung der Fragen/Aufgaben in Moodle gibt es die jeweils die Felder „Spezifisches Feedback“ und „Allgemeines Feedback“, in denen sich jeweils sehr detailliert Musterlösungen (aus meiner Sicht im Allgemeinen Feedback) und spezifische Rückmeldungen bezogen auf die Eingaben der Studierenden („Rückmeldebaum“ in STACK) eintragen lassen. Für eine reine Lernanwendung lassen sich diese detaillierten Rückmeldungen gezielt ein- oder ausblenden. Damit lassen sich dieselben Aufgaben über die Steuerung der Anzeige der Rückmeldung in unterschiedlichen Kontexten einsetzen. In den Mathematiktests verwenden wir Standardaufgaben, für die sich die Lösungen aus dem Vorlesungsmaterial ergeben. Dadurch, dass eine beliebige Anzahl an Versuchen erlaubt ist, sollte natürlcih nciht mit dem ersten Aufruf die Musterlösung für alle diese Aufgabentypen „abgegriffen“ werden können.

Darstellung

- Unter „mehr anzeigen“ verbirgt sich die Option „Blöcke bei den Testversuchen anzeigen“, die wir mit „Ja“ angegeben haben. Damit sind sich die Blöcke, die für den Kurs sichtbar sind, auch während des Tests sichtbar. In unserem Fall ist das ein selbsterstellter Textblock mit Eingabehilfen zu den mathematischen Symbolen (zusätzlich zur Testnavigation zwischen den Aufgaben).

- An den folgenden beiden Blöcken haben wir nichts geändert, da wir keine weiteren Sicherheitsvorkehrungen wie ein Safe Exam Browser oder die Angabe einer festen IP-Adresse (für die Durchführung von Tests an Hochschulrechnern) oder eines zusätzlichen Passworts benötigen.

Wie sich Blöcke grundsätzlich anlegen lassen, habe ich in dem folgenden Blogbeitrag beschrieben:

Gesamtfeedback

- Nur für den echten Test relevant.

An den letzten Einstellugen haben wir ebenfalls nichts geändert.

Einstellungen: Tests/summative Bewertung

Für den „echten“ Test wird die Spielwiese kopiert und die Einstellungen werden an folgenden Stellen modifiziert.

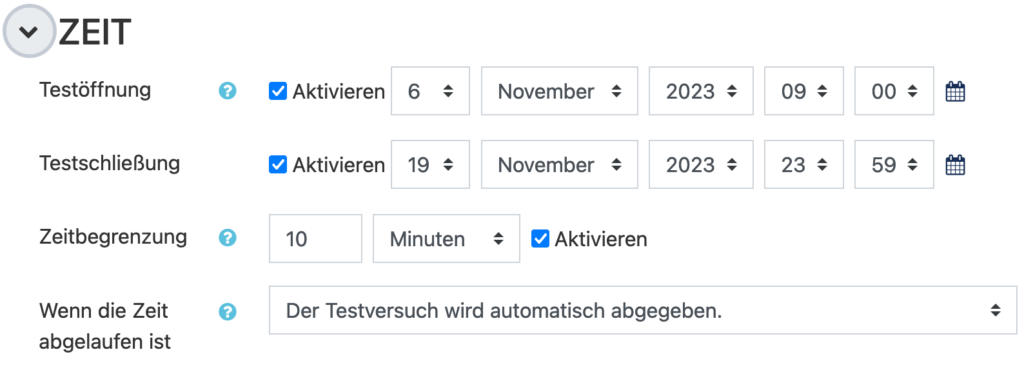

Zeit:

Der Test erhält jetzt ein wohldefiniertes Start- und Enddatum

Bewertung:

Hier sind nur noch 2 Versuche erlaubt, von denen ebenfalls der bessere gewertet wird.

Überprüfungsoptionen:

Hier werden nun alle Feedbackoptionen nach Abschluss des Tests (also nach den 2 Wochen sichtbar). Nach der Durchführung lassen sich also auch potentiell hinterlegte Musterlösungen einsehen.

Weitere Zugriffbeschränkungen:

Hier lässt sich jetzt eintragen, dass zwischen zwei Versuchen mindestens ein Woche liegen muss (wer beim ersten Mal nicht bestanden hat, sollte noch einmal eine Weile üben). Dies muss den Studierenden natürlich vorher deutlich kommuniziert werden, denn wer in der ersten Wochen seinen Testversuch nicht abschließt, hat keinen Zweitversuch mehr.

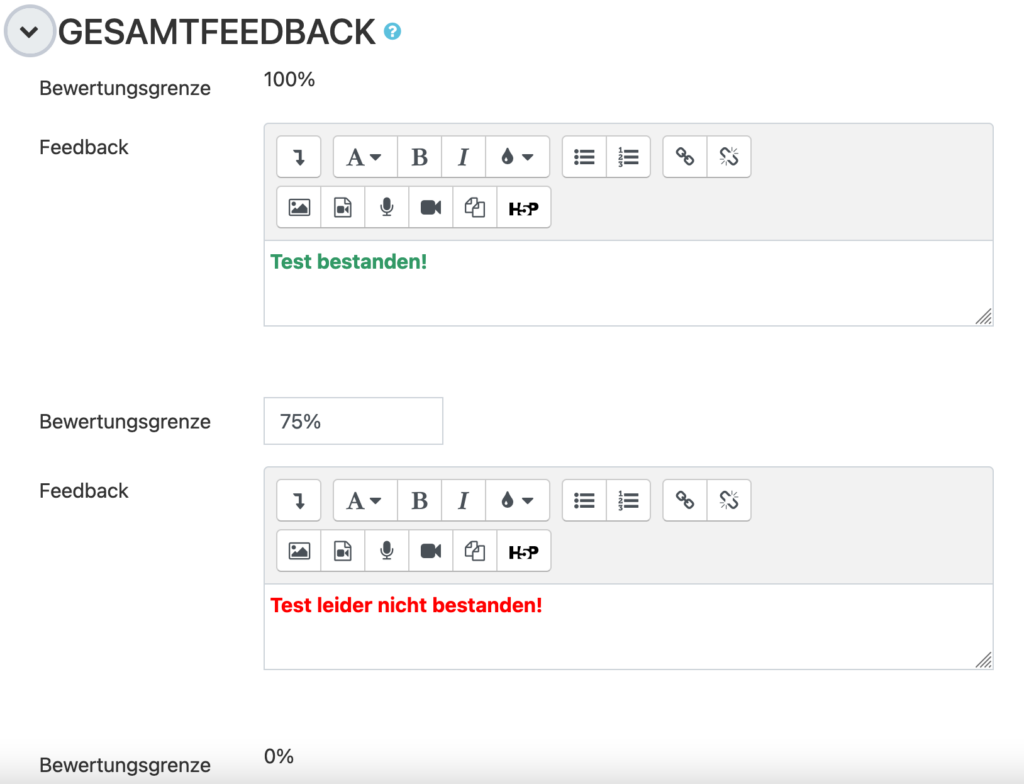

Gesamtfeedback:

Wichtig! Hier lässt sich Feedback bezogen auf die erreichte Gesamtpunktzahl eintragen in beliebiger Granularität. Die Grenzen müssen dabei zwingend als Prozentzahlen (und nicht als Dezimalangaben) eingetragen werden! 75% ist in dem Beispiel die Untergrenze des oberen Kommentars, d.h. der Kommentar „Bestanden“ wird bei größer oder gleich 75 % angezeigt. Wichtig: Für die Studierenden ist nicht ersichtlich, dass die erreichte Punktzahl und der Kommentar unabhängig voneinander konfiguriert werden. Hier ist also eine mögliche Fehlerquelle, wenn die Prozentzahlen nicht zusammenpassen, wenn „Bestanden“ angezeigt wird, obwohl die Mindestpunktzahl nicht erreicht wurde (oder umgekehrt).

Referenzen

[1] M. Clincy, K. Melzer, A. Eichhorn, und N. Verné, „Denn sie wissen, was sie tun: ‚STACK – Üben mit Feedback 4.0‘“, Spektrum, Bd. 49, S. 10–12, 2020, [Online]. Verfügbar unter: https://www.hs-esslingen.de/fileadmin/media/Service_Einrichtungen/ROEM/epaper/spektrum_49/index.html

[2] M. Scriven, „The methodology of evaluation“, in Perspectives of curriculum evaluation, R. W. Tyler, Hrsg., Chicago: Rand McNally education series, 1967.

[3] M. Clincy, K. Melzer, G. Schaaf, A. Eichhorn, und N. Verné, „Inside the “Sandbox”: The Effects of Unlimited Practice for Summative Online-Tests“, Int. J. Emerg. Technol. Learn. IJET, Bd. 17, Nr. 23, S. 115–127, Dez. 2022, doi: 10.3991/ijet.v17i23.35939.

[4] M. Clincy, K. Melzer, G. Schaaf, A. Eichhorn, und N. Verné, „Online midterm tests between summative and formative assessment – Online-Midterms zwischen formativer und summativer Bewertung“, Z. Für Hochschulentwicklung, S. 141–156, 2022, doi: 10.3217/ZFHE-17-01/09.

[5] B. S. Bloom und M. D. Engelhart, Hrsg., Taxonomie von Lernzielen im kognitiven Bereich, 5. Aufl., (17.-21. Tsd.). in Beltz-Studienbuch, no. 35. Weinheim: Beltz, 1976.