Ich hatte in Edinburgh die Gelegenheit, mich einmal direkt mit Chris Sangwin, dem „Vater“ von STACK, auszutauschen. Zwei neue Features waren dabei von besonderem Interesse: STACK hat jetzt eine Versionskontrolle implementiert und die Erstellung von Testfällen wurde deutlich vereinfacht. Die Erstellung der Testfälle rechtfertigen einen eigenen Blogeintrag, hier aber eine kurze Information zur Aktualisierung der Fragen in der Fragensammlung. Bei der Erstellung von neuen Fragen ist mir aufgefallen, dass sich neben den STACK-spezifischen Änderungen in der neuen Moodle-Version auch eine hilfreiche Erweiterung der Parameter in der Fragensammlung verbirgt. Diese bereitet die statistischen Daten eines Tests direkt auf für eine Auswertung der Aufgabenqualität.

Ich möchte hier beides kurz vorstellen, die STACK-Änderung zur Versionskontrolle sowie die Moodle-Aktualisiserung des Fragenkatalogs (mit einer kleinen Einführung in Moodles-Statistik-Auswertung).

STACK – Versionskontrolle

Bisher haben wir die Versionskontrolle bei der Erstellung von STACK-Aufgaben immer händisch durchgeführt, d.h. bei der Aktualisierung oder Korrektur von Aufgaben eine alte Aufgaben dupliziert, diese Kopie dann entsprechend überarbeitet und mit einem neuen Namen (meistens ein Hochsetzen eines Suffixes „_V00X“) gekennzeichnet. Das ist nicht nur fehleranfällig, sondern führt auch zu dem Problem, dass Aufgaben, die bereits in einem Test eingesetzt werden, jedes Mal mit ihrer neuen Version ersetzt werden müssen – gerade bei Korrekturen ist das natürlich nicht gut.

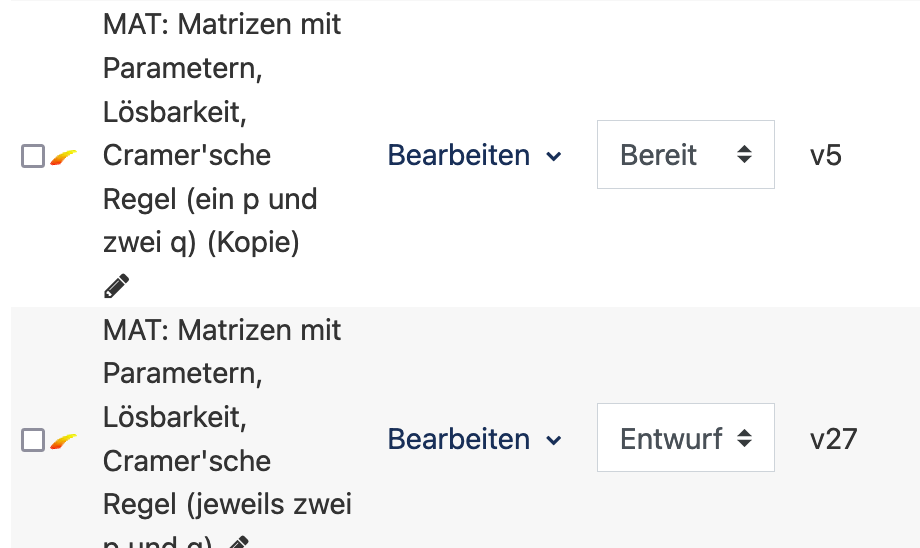

Stattdessen legt STACK jetzt bei jedem Speichern automatisch eine neue Version an. In der Fragensammlung steht die Versionsnummer in der vierten Spalte – die dritte Spalte gibt an, ob die Aufgabe überhaupt eingesetzt werden kann oder sich noch im Entwurfsstatus befindet.

Bei der Versionskontrolle ist die Default-Einstellung so, dass immer die aktuelle Version genommen wird. Allerdings lässt sich auf jede alte Version zurückgreifen (was sich bei versehentlichem Speichern und Löschen für mich schon als sehr hilfreich herausgestellt hat).

Moodle: Statistische Daten in der Testauswertung und der Fragensammlung

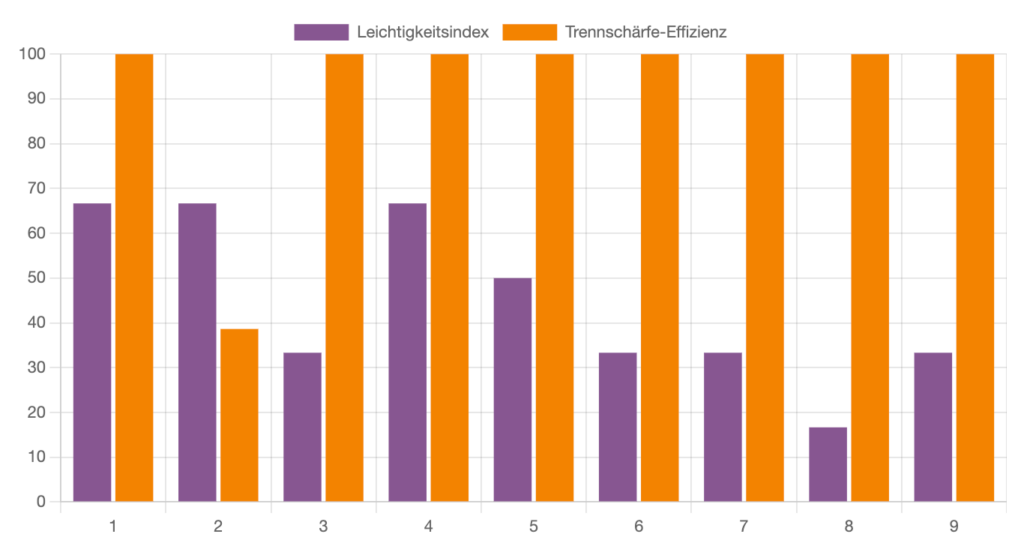

Wie gut Fragen ankamen, ließ sich für die eingesetzten Fragen aus den Tests auch bisher schon in Moodle unter „Bewertung -> Statistik“ abfragen. Dort werden neben einigen tabellarisch aufgeführten Kenngrößen grafisch der Leichtigkeitsindex in gelb („Mit welchem Prozentsatz wurde diese Frage im ersten Anlauf richtig beantwortet“) sowie die Trennschärfe-Effizienz in lila („Misst die Frage etwas anderes als eine andere Frage, sind die Fragen unabhängig voneinander“) – Details zur genauen Berechnung finden sich in der Moodle-Dokumentation: https://docs.moodle.org/403/de/Test-Statistik

Die Anzeige der Statistik eines Tests liefert weiterhin eine Test-Strukturanalyse (direkt oberhalb des Graphen zur Trennschärfe -Effizienz und zum Leichtigkeitsindex), bei der sich für die einzelnen Fragen anzeigen lässt, welche Varianten ausgegeben und wie beantwortet wurden:

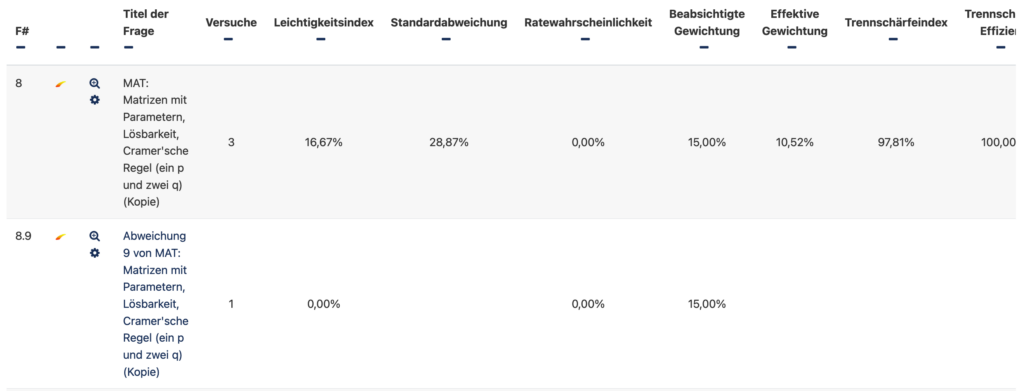

Für jede Frage lassen sich unter „Details anzeigen“ die Verteilung der Antworten anzeigen auf einer eigenen Seite. Hier lässt sich nun beispielsweise ablesen, dass der Test zwar insgesamt deutlich häufiger versucht wurde, diese spezifische Frage aber nur drei Mal beantwortet wurde mit der Auswertung der jeweiligen Varianten:

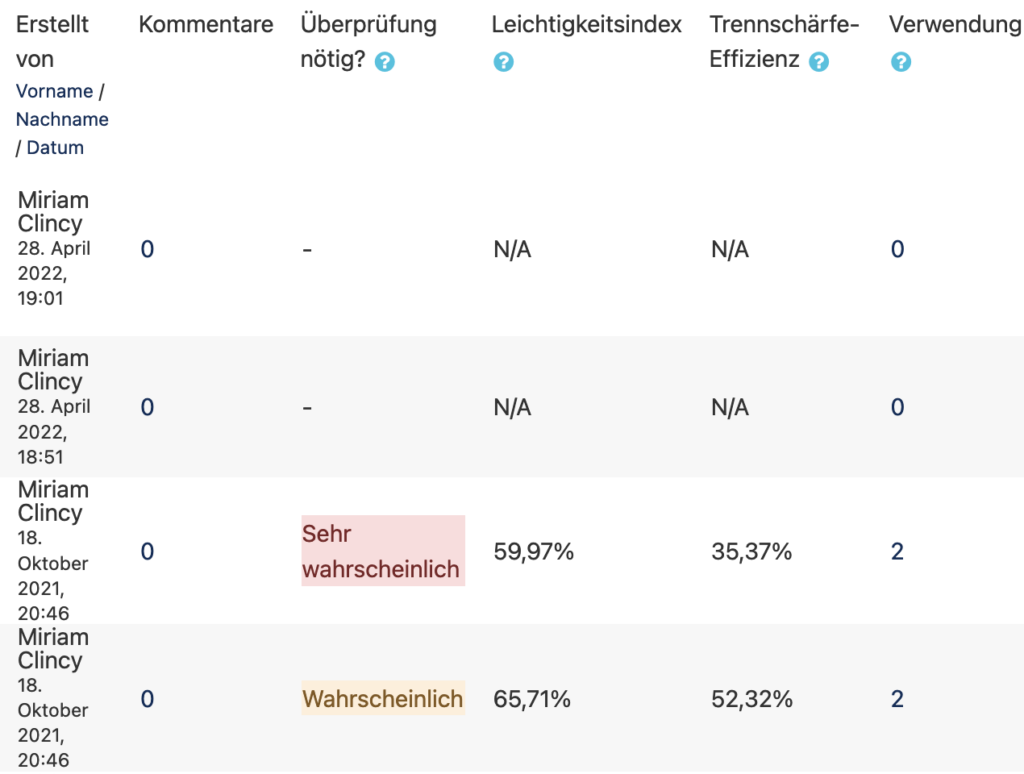

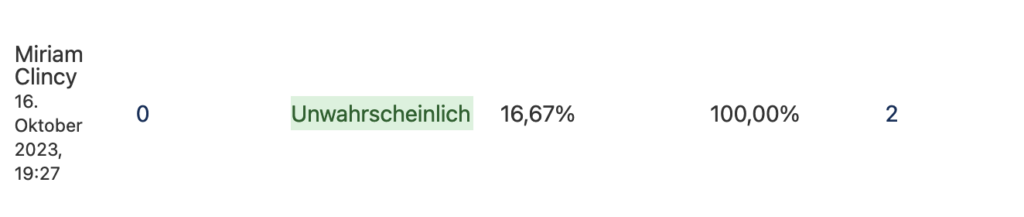

Neu ist nun, dass Moodle die Übersichtsdaten aus der Statistik direkt in der Fragensammlung anzeigt und Rückschlüsse darüber zieht, ob die Aufgabe überarbeitet werden muss. Diese Daten werden natürlich nur angezeigt, wenn die jeweilige Frage bereits im Test eingesetzt wurde und Daten vorliegen. Aufgaben, bei denen beispielsweise immer eine niedrige Punktzahl erzielt wird, obwohl die Gesamtergebnisse im Test hoch sind (oder umgekehrt), wo also die Bewertung dieser Frage nicht zum Gesamtbild passen, werden als problematishc angezeigt:

Aufgaben, bei denen sich keine solchen Diskrepanzen ergeben, werden grün markiert:

Um sich anzeigen zu lassen, wo die Aufgabe eingesetzt wurde und wie oft bereits beantwortet, lässt sich auf die Zahl in der Spalte „Verwendung“ klicken. Die 2 hier im Beispiel zeigt an, in wie vielen Tests diese Frage innerhalb des Kurses eingesetzt wurde. Beim Aufruf erscheint dann ein Fenster mit der Aufgabe und am Ende die Anzahl der Versuche für diese Aufgabe.

Zusammengefasst: An der Farbkodierung lässt sich also nun direkt in der Fragensammlung sehen, welche Fragen möglicherweise problematisch sind und ersetzt werden müssen – dabei weist die neue Funktionlität auch gleich auf die Tests hin, bei denen eine Auswertung der Statistik (wie oben) aufgrund großer Teilnahmezahlen am gewinnbringendsten ist.

Für die nächste Konzeption von Fragen sowie bei einer Überarbeitung der Tests sind diese neuen Einstellungen hoffentlich nicht nur für mich vielseitig nutzbar.